خبر خوب برای کسایی که با سئو (بهینه سازی سایت برای موتورهای جستجو) سروکله میزنن!

مایکروسافت یه سری آپدیت باحال برای ابزار وبمستر Bing (Bing Webmaster Tools) منتشر کرده که به بهتر دیده شدن سایتتون توی موتور جستجوی Bing و بقیه جاها کمک زیادی میکنه.

این آپدیتا شامل دو تا گزارش جدید هستن:

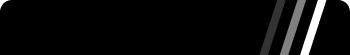

- گزارش (Bing IndexNow Insights): این گزارش به شما نشون میده که آدرس های اینترنتی (URL) که با IndexNow ثبت کردید، چطور دارن کار میکنن و فراتر از اون، اطلاعات بیشتری هم بهتون میده.

- گزارش “بالاترین بینش های سئو” (Top SEO Insights): این گزارش مهم ترین مشکلات سئوی سایتتون رو بهتون نشون میده و بهتون کمک میکنه تا اونها رو برطرف کنید.

خلاصه اینکه، این آپدیتای جدید بهتون کمک میکنن تا سایتتون رو بهتر توی نتایج جستجو بالا بیارید و راحت تر دیده بشید.

یه نکته جالب دیگه: تعداد آدرس های اینترنتی ثبت شده با “IndexNaw” به 2.5 میلیارد تا رسیده که نسبت به 6 ماه پیش، دو برابر شده! همچنین، 17 درصد از کلیک های روی نتایج جستجوی وب، مربوط به آدرس هایی هست که با “ایندکس ناو” ثبت شدن. این یعنی “ایندکس ناو” داره به یه ابزار قدرتمند برای دیده شدن توی نتایج جستجو تبدیل میشه.

گزارش های IndexNow Insights: اطلاعات مفیدتر برای دیده شدن بهتر سایت شما

ابزار جدید “بینگ ایندکس ناو اینسایتس” (Bing IndexNow Insights) به گفته فابريس كانل، مدیر محصول ارشد مایکروسافت، “با ارائه بینش های کاربردی در مورد آدرس های اینترنتی (URL) ثبت شده با ایندکس ناو، به بهبود دیده شدن و رتبه بندی آنها کمک می کند.” این گزارش علاوه بر معیارهای کلی، گزارش های دقیق تری هم در اختیار شما قرار می دهد.

گزارش قبلی، فقط URL های ثبت شده در 24 ساعت گذشته را نشان می داد. اما گزارش جدید، تعداد URL ها را به همراه روند تغییرات و اطلاعات کاربردی بیشتری نمایش می دهد. همچنین، این گزارش URL هایی را که از طریق خزیدن (crawling) یا روش های دیگر و نه با ایندکس ناو کشف شده اند نیز به شما نشان می دهد.

یه عالمه قابلیت باحال برگشته! بیایید ببینیم چیا توش گیرمون میاد:

- دردسرهای URL های خزیده و وضعیت URL های ثبت شده رو بفهم: دیگه نگران این نباشی که چرا یه URL خاص ایندکس نشده! این گزارش بهت میگه چه مشکلاتی ممکنه وجود داشته باشه.

- تعداد URL های ثبت شده، خزیده شده و ایندکس شده رو ببین: حالا میتونی دقیقاً ببینی چندتا URL رو ثبت کردی، چندتا خزیده شدن و چندتا هم ایندکس شدن. دیگه لازم نیست حدس بزنی!

- آخرین 1000 URL ثبت شده رو چک کن: ببین کدوم URL ها تازه ثبت شدن، کی ایندکس شدن و آیا با تاخیر ثبت شدن یا نه. با این اطلاعات میتونی بهتر برنامه ریزی کنی.

- ببین URL ها از کجا ثبت شدن: فرقی نمیکنه URL ها رو با کلودفلر، وردپرس، خودت دستی یا هر روش دیگه ای ثبت کرده باشی، این گزارش بهت نشون میده.

- لینک های مهمی که جا مونده رو پیدا کن: این بخش بهت نشون میده کدوم لینک های جدید که کشف شدن دارن کلیک میخورن ولی تو ایندکس ناو نبودن. با این اطلاعات میتونی جلوی این مشکل رو بگیری.

- اطلاعات دقیق درباره خطاهای URL ها: اگه URL ای ایندکس نشده، این گزارش بهت میگه مشکل از چی بوده، مثلا کیفیت محتوا، ربات های مسدود کننده، خزیده نشدن، ایندکس شدن یا لینک های خراب.

- برای URL های ایندکس نشده عمیق تر بررسی کن: میتونی برای هر URL غیر ایندکس شده، نمونه URL ها، زمان ثبت و راه حل های رفع مشکل رو ببینی. دیگه لازم نیست دنبال سوزن تو انبار کاه بگردی!

- روند ایندکس شدن رو برای تحلیل و گزارش بیشتر، صادر کن: اگه میخوای اطلاعات رو با بقیه به اشتراک بذاری یا بیشتر تحلیل کنی، میتونی روند ایندکس شدن رو به صورت خروجی بگیری.

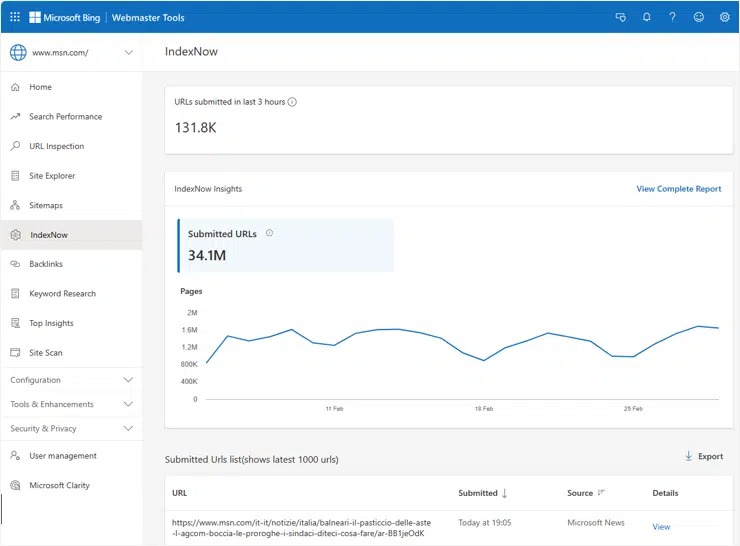

گزارش برترين بينش های سئو (Top SEO Insights)

یه گزارش جدید دیگه هم به ابزار وبمستر Bing اضافه شده به اسم “برترين بينش های سئو” (Top SEO Insights). این گزارش یه لیست مرتب و اولویت بندی شده از مهم ترین مشکلات سئوی سایت شما رو به نمایش میذاره که توسط Bing شناسایی شده.

مایکروسافت میگه: “برترین بینش ها مجموعه ای از توصیه های شخصی سازی شده و اولویت بندی شده رو ارائه میده که به وبمسترها اجازه میده تا مهم ترین کارها برای بهینه سازی وب سایت رو شناسایی و روی اونها تمرکز کنن.” این بخش به شما کمک میکنه تا مشکلات کیفیت محتوا، نحوه بهبود پوشش ایندکس شدن، ردیابی پیشرفت و تاثیرگذاری، یا بهینه سازی داده های ساختاریافته و بک لینک ها رو حل کنین.

با این آپدیت های جدید، دیگه نگران دیده شدن سایتتون توی نتایج جستجو نباشین! Bing اینجاست تا بهتون کمک کنه!

در اینجا یک اسکرین شات از گزارش تمرین با جزئیات بیشتر آمده است:

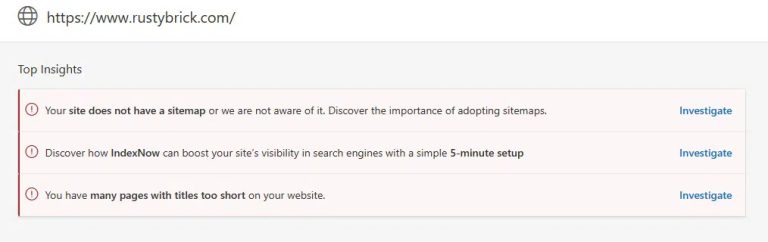

ابزار وبمستر Bing یه شکل جدید شده!

- قبلا یه بخش جداگانه به اسم “سئو” (SEO) تو این ابزار بود. حالا دیگه اون بخش رو برداشتن و همه چی رو مستقیم تو صفحه اصلی لیست کردن. خلاصه اینکه دیگه دنبال بخش “سئو” نگردین!

- یه سری تغییرات دیگه هم دادن که خیلیم جزئی هستن. مثلا اگه شما از قابلیت “ثبت آدرس اینترنتی (URL) تو بینگ” استفاده نمی کنید، گزینه مربوط به اون تو لیست اصلی نمایش داده نمیشه. اینجوری صفحه اصلی خلوت تر و مرتب تر میشه.

با این تغییرات، دسترسی به بخش های مهم راحت تر شده و دیگه لازم نیست تو بخش های مختلف دنبال گزینه مورد نظرتون بگردین.

چرا باید از IndexNow استفاده کنیم؟

اگه هنوز از “ایندکس ناو” (IndexNow) استفاده نمی کنید، بهتره یه کم تحقیق کنید و ببینید چطوری میتونید ازش روی سایتتون استفاده کنید. اگه از “کلودفلر” (Cloudflare) استفاده می کنید، فقط کافیه یه دکمه رو روشن کنید، به همین سادگی! تازه خیلی از سیستم های مدیریت محتوا (CMS) هم به طور پیش فرض از “ایندکس ناو” پشتیبانی می کنن.

همچنین، یادتون نره ابزارهای جدیدی که به “ابزار وبمستر بینگ” (Bing Webmaster Tools) اضافه شدن رو هم چک کنید.

ایندکس ناو چیه؟

“ایندکس ناو” یه راهی برای صاحبان سایت هاست که بتونن به سرعت موتورهای جستجو رو از تغییرات جدید محتوای سایتشون مطلع کنن. “ایندکس ناو” یه جور سیستم اطلاع رسانی ساده است که به موتورهای جستجو اطلاع میده که یه آدرس اینترنتی (URL) و محتوای اون اضافه شده، تغییر کرده یا حذف شده. اینطوری موتورهای جستجو میتونن به سرعت این تغییرات رو تو نتایج جستجو اعمال کنن. “اشتراک گذاری مشترک ایندکس ناو” از ماه ژانویه 2022 به طور کامل فعال شده.

چطوری کار می کنه؟

این سیستم خیلی راحته، فقط کافیه یه کلید (key) روی سرورتون درست کنید و بعد اون آدرس اینترنتی (URL) رو به موتور جستجو بفرستید تا به “ایندکس ناو” خبر بدین که تغییری اتفاق افتاده. مراحلش به این صورته:

- با استفاده از ابزار آنلاین تولید کلید، یه کلید که با این سیستم سازگار باشه، درست کنید.

- این کلید رو تو یه فایل متنی با اسم همون کلید، تو ریشه (root) سایتتون قرار بدین.

- از زمانی که آدرس های اینترنتی (URL) اضافه، تغییر یا حذف شدن، شروع کنید به ارسال اونها. میتونید هر بار یه URL یا یه مجموعه URL رو با هم ارسال کنید.

- فرستادن یه URL به سادگی فرستادن یه درخواست ساده HTTP هست که شامل URL تغییر یافته و کلید شما میشه.

اینم نمونه هایی از آدرس های اینترنتی (URL) برای فرستادن URL به “ایندکس ناو”: